Unterseiten bei Suchmaschinen bekanntmachen oder für Suchmaschinen ausschließen

Mit Hilfe der beiden Dateien sitemap.xml, die die Sitemap der Webseite enthält, und der robots.txt wird gesteuert, was von Suchmaschinen auf der Webseite durchsucht werden darf und was nicht.

Über die Sitemap steuern, welche Unterseiten durchsucht werden dürfen

Eine Sitemap ist eine XML-Datei, die eine Liste aller Unterseiten der entsprechenden Webseite zur Verfügung stellt, die über Suchmaschinen gefunden werden sollen. Diese crawlen die Inhalte auf der Webseite meist auch ohne Sitemap, insofern sie über eine interne Verlinkung erreichbar sind - über die Sitemap kann jedoch sichergestellt werden, dass auch der gesamte Inhalt gefunden werden kann. Mit Hilfe der Sitemap können sich die Suchmaschinen über die Struktur und Gliederung der Webseite informieren und erfahren darüber hinaus, wann auf den jeweiligen Unterseiten die letzte Änderung durchgeführt wurde. Um Google zu helfen, die Webseite besser zu erfassen und zu indexieren, sollte die Sitemap zusätzlich auch bei der Google Search Console eingereicht werden.

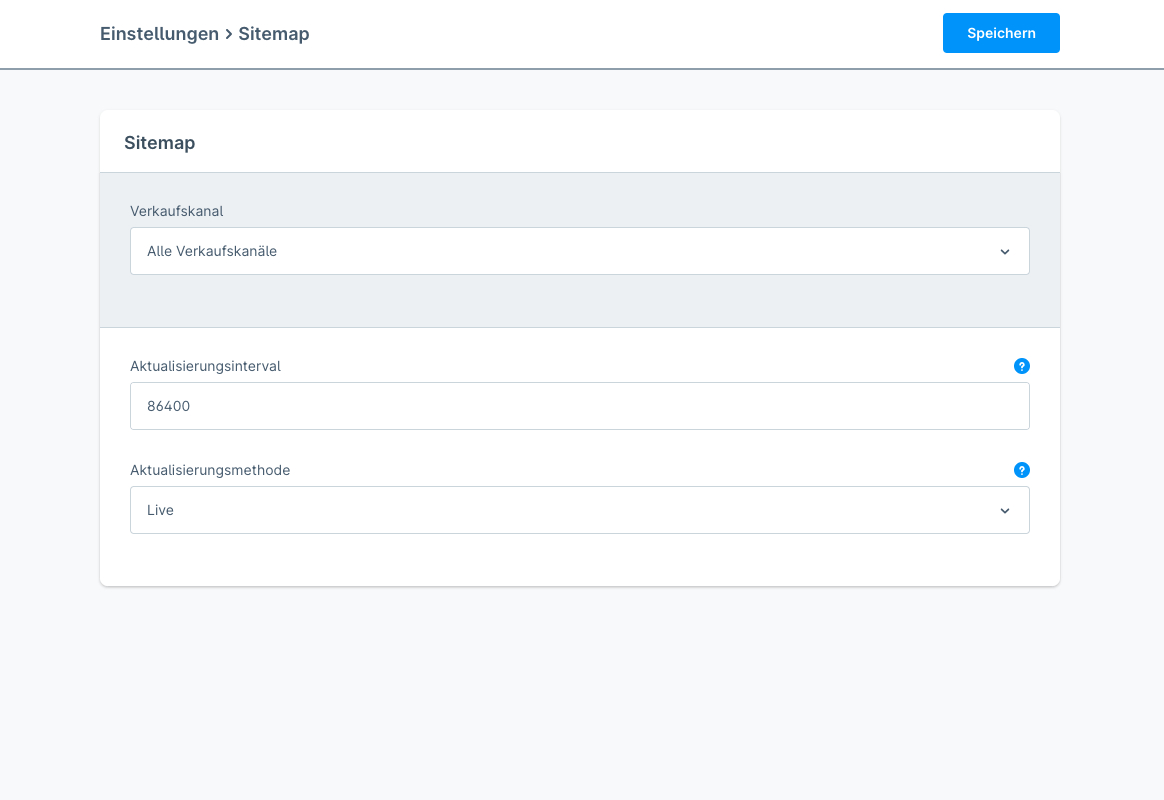

In Shopware 6 wird die Sitemap automatisch angelegt und je nach vorgenommener Einstellung unter "Einstellungen", "Shop" und "Sitemap" entweder "manuell", "geplant" oder "live" aktualisiert. Wenn beim Feld "Aktualisierungsmethode" der Wert "Manuell" ausgewählt wurde, wird die Sitemap ausschließlich über einen Konsolenbefehl erzeugt und aktualisiert. Diese Methode ist nur bedingt zu empfehlen, da der Befehl jedes Mal ausgeführt werden müsste, wenn eine neue URL hinzugefügt oder eine alte entfernt werden soll. Beim Wert "Geplant" wird sie stattdessen über geplante Tasks (beispielsweise sogenannte CronJobs) in regelmäßigen Abständen aktualisiert. Bei der "Live"-Methode wird die Sitemap in regelmäßigen Intervallen aktualisiert, das gewünschte Intervall kann dazu im Feld "Aktualisierungsintervall" festgelegt werden.

Die passende Einstellung richtet sich vor allem auch danach, wie oft sich Produkte und Kategorien auf der Webseite ändern, also eine URL wegfällt oder dazukommt. In den meisten Fällen reicht es aus, die Aktualisierungsmethode "Live" mit dem Aktualisierungsintervall "86400" auszuwählen. Der Wert "86400" entspricht dabei 24 Stunden.

Über die robots.txt bestimmte Unterseiten für Suchmaschinen ausschließen

Es gibt Unterseiten, die vor den Suchmaschinen verborgen bleiben und vom Crawling ausgeschlossen werden sollen. Dazu gehören beispielsweise die Unterseiten des Checkouts, des Kundenkontos oder die Seiten, die über die Suchfunktion oder die Filterung erzeugt werden. Dafür eignet sich eine Textdatei mit dem Namen robots.txt am besten, da ein Crawler diese Datei zuerst aufruft, bevor er die restliche Webseite durchsucht. Diese Datei, die sich zwingend im public-Verzeichnis befinden muss, umfasst gewisse "Befehle" oder "Regeln", über die sich das Verhalten des Crawlers in Bezug auf die Indexierung steuern lassen. Die Disallow-Direktive sagt dem Crawler, dass er dieses bestimmte Verzeichnis nicht crawlen darf. Die Allow-Direktive erlaubt es dagegen, dieses Verzeichnis zu crawlen. Außerdem enthält die robots.txt im Idealfall auch den Pfad, wo die Sitemap zu finden ist. Der Inhalt der Datei könnte beispielsweise folgendermaßen aussehen:

User-agent: *

Allow: /

Disallow: /account/

Disallow: /account/address/

Disallow: /account/login/

Disallow: /account/order/

Disallow: /account/profile/

Disallow: /account/recovery/

Disallow: /checkout/cart/

Disallow: /search/*

Disallow: /widgets/

Disallow: /widgets/cms/

Disallow: /widgets/menu/

Sitemap: https://www.shopurl.de/sitemap.xml